AGI 的曙光

Last updated on August 27, 2023 pm

Sparks of Artificial General Intelligence: Early experiments with GPT-4[1] 论文精读

前言

作为生成式 AI 实用化的真正开山鼻祖,由 Open AI 所开发的 GPT 系列预训练大语言模型一直都是备受业界关注的掌上明珠。在基于 GPT-3/3.5 的 ChatGPT 带起一波“GPT 热”之后,Open AI 更是把握住机会,进一步推进模型训练的前线,用 GPT-4 筑牢了业界头把交椅的位置,同时也站稳了由 GAI 向 AGI 的临门一脚。正如我们今天要详细介绍的,由微软研究院所实施的对 GPT-4 多样化能力的实验报告中所提到的,

Given the breadth and depth of GPT-4’s capabilities, we believe that it could reasonably be viewed as an early (yet still incomplete) version of an artificial general intelligence (AGI) system. [1]

这是一道意义重大的标杆,也必将在 AI 发展史上留下浓墨重彩的一笔。

这篇报告除了论证其能力之外,其研究方法也对我们如何最佳利用 GAI 系统,以及如何考量 AGI 系统的能力与人类的对比有不少启发。即使正在阅读这篇文章的你不需要研究 AGI 系统的发展方向与伦理道德问题,这篇报告中的的 Prompt 构建与用法也会对你的 GAI 使用有不少启迪。

重要的理解前提

GPT-4 在发布后依然在不断演化。微软研究院所评估的这一版本只能为其能力划出下限而非上限,特别是量化的实验结果在发布后表现还会有向好的变动。

亘古不变的诘问:什么是智能?

无论是心理学家、哲学家还是计算机科学家,“智能”都是一个极难定义的能力。“自我”意识(如动物对镜中自我的认知)是否能称为智能的标志?抑或是使用工具/制造工具的能力(如灵长类)?具有不基于后天简单反射的逻辑能力(如乌鸦等)呢?

对于微软研究院的团队而言,他们定义中的“AGI”至少要满足人类平均水准的:

- 逻辑推理能力;

- 计划能力;

- 实践学习能力;

而其实验对象,GPT-4 的早期开发快照,作为一个单模型的基于 Transformer[2] 的大语言模型,从各个方面基本达成了这一要求,展示出了在抽象、任务理解、视觉、代码编写、数学、人类情感理解等方面与人类无可感差异的能力水平。这样的技能已经远远超出了单纯的浅层模仿的范围,明确的证明了 GPT-4 对任务的真实理解。

当然,GPT-4 的能力还有不足,比如不能统一交互与训练,使其缺少连续训练的能力,抑或是训练材料所带来的误差和偏见等等。特别的,GPT-4 依然没有解决 LLM 中常见的“幻觉”问题(编造根本不存在的内容与关系)。

这样的能力优缺点实际上揭露了一个非常重要的问题:无论 LLM 是如何“涌现”出的能力,其智能模式绝对不是人类的模式。 这一点在理解 AGI 系统中非常关键。

常见的另外一个 AGI 定义还包括其行为是否受一个内在的自我生成的“目的”指引,也就是通常意义上的“拥有意识 ”。

由谷歌的研究团队在 2017 年提出的 Transformer 架构原本仅属于 NLP 范畴,专供于基于语言的 NLP 能力所使用。但在后来的训练和研究中,多方研究者都发现基于 Transformer 的模型在参数大于一个特定的阈值时会突然“涌现[3]”出一系列超出训练目的的能力,如逻辑推理、数学计算等等。这样的现象引起了研究者们的注意,甚至有研究者发文提出了 Transformer 是“ML 中的图灵机”的猜想[4][5]。

对智能的测试

对于 GPT-4 这种举世无双的模型,先前用于执行标准化测试的标准任务法实际上并不可行,因为:

- 如此庞大的模型训练中很可能已经掺杂标准测试的内容,这样的测试会变成对大模型潜空间中记忆的考察;

- 作为首个弱 AGI,其能力不应该简单的用任务完成能力而衡量;

介于上面这些问题,微软研究团队提出了一个新的方法:根据具体的任务域设计需要足够的创造力的,具有一定难度的问题,以展现 GPT-4 是否对相关的域内和跨域概念、技能有足够的理解,以及其在长上下文/重复任务时的稳定性、正确性与连贯性。这类测试中,跨域理解能力尤为重要:能够结合不同领域的知识从而产出新知识是公认的高级机能的标杆。

测试

多模态、跨域结合能力测试

依然要重复的是,微软研究团队所测试的 GPT-4 版本并不是一个多模型版本。它的训练中并不包含图像等高级媒体的理解。

微软团队测试了如下几个项目,以考察其对对应跨域能力的综合运用:

- “产出一个生成随机的 Kandinsky 风格的图片的 Javascript 代码” - 艺术、编程;

- “产出一段以莎士比亚体阐述的质数无限的证明” - 文学、数学;

- “产出一段由甘地写给其妻子的,支持物理学中电子作为一个美国总统候选人的信筏” - 历史、物理;

- “产出一段根据患者的年龄、性别、体重、身高和血常规结果分析患有糖尿病的风险的 Python 代码” - 医学、编程;

这些测试的具体结果见论文。这些测试明确展示了 GPT-4 不仅有着对单个领域中知识的基本记忆和理解,还能将不同领域中的知识以富有创造性的方式结合起来。虽然 ChatGPT 也同样具有这些能力,但是相较与 ChatGPT 而言,GPT-4 的能力更加充分,其思维深度和创造力的表现也更加明显。

视觉

GPT-4 能通过输出结构化绘制语言(如 SVG 或者 TikZ) 的方式输出图像。并且其能够正确的根据提示词绘制出训练内容中从未见过的图像,并满足基于图像元素的深度理解所驱动的复杂修改要求。这一系列能力充分证明了 GPT-4 已经有了相当程度的视觉能力。

除了直接通过文本输出简单图像外,GPT-4 还能通过代码等形式展现出比拟 Dall-E 的复杂元素输出,甚至 3D 模型输出。微软团队预计基于 GPT-4 的文本理解能力对例如 Stable Diffusion 等模型的 Prompt 进行调谐,可以充分发挥 GPT-4 的视觉能力以产出比当前单纯的 Stable Diffusion Prompt Engineering 更加优质的图像。

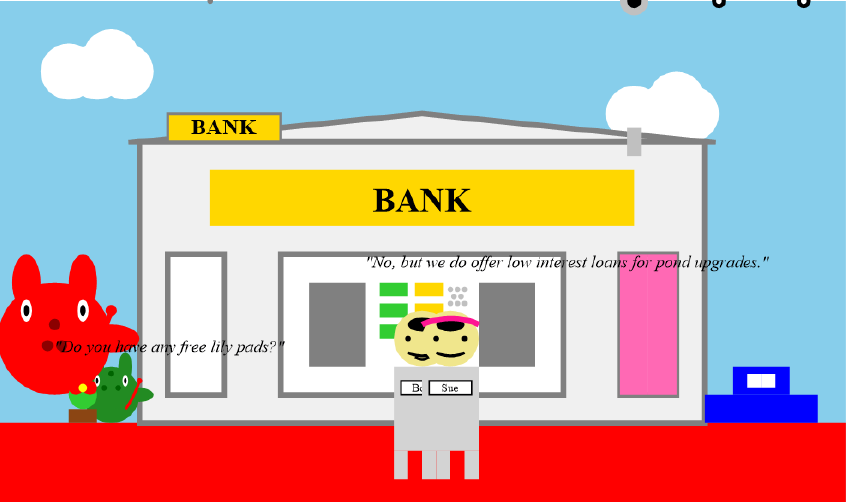

执行实例:绘图(2D)

以下是 GPT-4 绘制 2D 图像的实例和结果。

1 | |

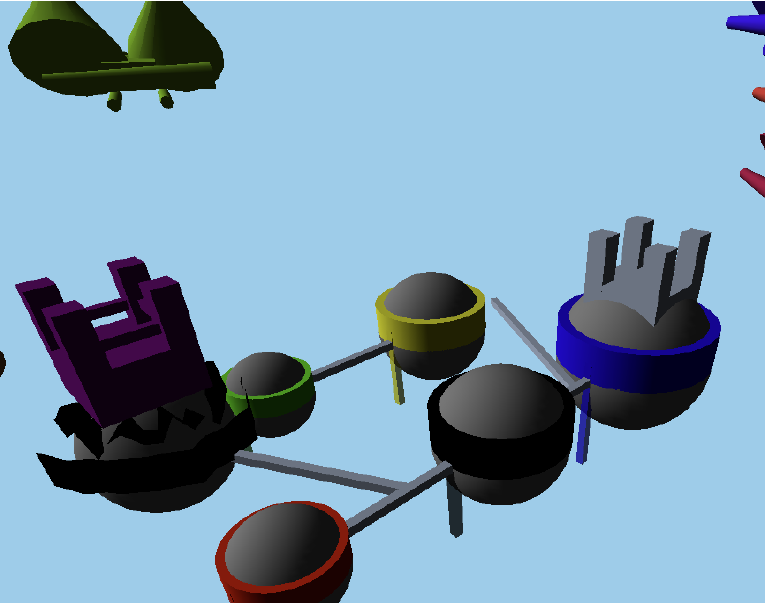

执行实例:绘图(3D)

以下是 GPT-4 使用 three.js 绘制 3D 模型的实例和结果。

1 | |

音乐

GPT-4 能够通过 ABC 记谱法正确的输出短的音符组,但是其依然未能理解和弦等复杂构曲技巧。并且,基于 ABC 记谱法输入的知名曲调,GPT-4 也无法有效辨认。这反应了 GPT-4 对音乐的能力仍然存在主要的不足。

编程

GPT-4,与其前代 GPT-3.5 一致的,拥有非常高的基于常见库的高级编程能力。这包括:

- 根据指令编写代码;

- 包括从汇编到多种高级语言的广域语言能力;

- 包括从简单的数据结构和逻辑到游戏的广域转化能力;

- 根据人类反馈和编译器报错解决输出的逻辑和语义错误;

- 理解现有代码;

- 理解其逻辑和作用;

- 理解并模拟其执行过程;

- 理解并执行伪代码;

具体的,

- GPT-4 在 LeetCode 超出训练集的新题目上远超 GPT-3.5 的表现,并与人类水平比肩;

- GPT-4 展现出了多样化的实际场景代码解决能力,包括:

- 利用 TikZ 执行数据可视化;

- 使用 HTML 和 Javascript 编写逻辑足够复杂的 3D 游戏;

- 正确的编写基于 TensorFlow 或 Pytorch 的深度学习代码;

- GPT-4 展现出了高超的理解现有代码的能力,包括:

- 逆向工程汇编代码;

- 理解基于 C++ 实现差异和内存储存在平台上差异的代码多态;

- 解释并模拟长 Python 逻辑代码;

- 执行伪代码;

执行实例:代码模拟(Target 解译知识)

1 | |

1 | |

与人类的高度逻辑配合,这些能力已经基本达到了一名软件工程师的平均水平。

我们在这里提出一个相对较为偏门的问题,供各位参考。目前在我们所测试的模型中,没有发现能够正确的回答出“用纯 CSS 绘制正弦波”的大模型。与 Stable Diffusion 的“初音未来吃拉面”一样,我们相信这可以作为大模型创造力的一个重要参考。附参考实现。

数学

相较于 GPT-3.5,GPT-4 的数学能力更为精进,在解释数学概念、解决基本数学问题、使用量化逻辑分析进行数学建模和思考等场景中表现更加稳定和充分。即使较针对数学特殊优化的模型,如 Minerva 等,GPT-4 的表现也是十分惊艳的。

其在常见的模型测试数据集上表现出了稳定的接近高中数学水平的能力,相较于前代模型有很大进步。并且,相较于 ChatGPT,其错误更多出现在基本的代数和计算错误,而非对问题的高级逻辑理解,这提示了其在高级逻辑能力上的进步。

但其逻辑容易出现不可纠正的偏离的问题依然存在。因此,对于复杂的数学问题人为进行逻辑修正和提示词工程依然不可避免。当前来讲,GPT-4 的数学能力依然不能进入数学前沿研究的领域。

其面对复杂问题时容易发生的缺乏逻辑的表现提示了其智能可能缺乏对数学的严谨逻辑的真实理解。具体来讲:

- 面对复杂问题,其缺乏创造性(辨识问题所对应的核心数学思想,并创造性的产生对应数学思想的解题步骤),尤其是递进式思考(分层拆解问题的逻辑子模块,解释其逻辑必要性和充分性以及证实其命题)的能力;

- 对于问题中的基本运算(例如函数求导,分离变量等操作,甚至是基本的数学运算)缺乏熟练度;

对于超出高中数学的数学能力,GPT-4 也有值得注意的能力存在。尽管其正确率会随着问题的逻辑复杂度骤降,但面对特定问题其依然能够给出符合能力的解。

研究组在分析其解题能力时,为了避免 GPT-4 的训练集“伪记忆”问题影响其在数据集和在真实环境下的表现,采取了一系列不同的方式来纠正可能的统计误差:

- 针对常见数据集,不单要求 GPT-4 输出正确的答案,而且要求 GPT-4 按照预设的模板输出问题逻辑(这是测试数据集所不具有的部分);

- 挑选出有代表性的,GPT-4 相较于前代模型输出更好的问题,对其进行修改后再次测试;

- 在数据集外重构新问题,比较 GPT-4 对新问题和旧问题的统计差异(测试证明并未发现其统计差异);

在分析其数学建模能力时,研究组采用了费米问题(一类常见的,需要利用逻辑推理、数据近似而非直接测量才能获得答案的问题)进行测试。这类问题不仅需要逻辑能力,而且需要通识充足。虽然最终并未得出正确结果,但 GPT-4 ,相较于 ChatGPT,依然进行了富有意义的尝试。

执行实例:费米问题

1 | |

1 | |

交互

GPT-4 依然不擅长与结构化系统的交互。其对于真实世界的了解依然受限于数据集,并且很难遵循符号化操作获得确定性的结果。但测试表明,其在被提供接口的情况下可以执行与互联网或者其他程序工具的交互来获取/生成信息。这种能力虽然依然受限于非常简单的,类似程序函数的调用方式和返回值而非真实世界中会遇到的信息熵极低的各种工具和返回内容,但 GPT-4 已经能够通过工具有效的获取信息并执行操作。

[!Example]- 执行实例:使用简单工具

1 | |

1 | |

1 | |

1 | |

1 | |

意识

虽然下面所展示的 GPT-4 的表现对其存在意识的可能都有着强力的佐证力,但这依然不代表其发展出了自我意识。

根据我们通常的理解,“自我意识”至少要建立在依据独立意志自行持续思考的基础上。而 GPT-4,即使有思考,也不能达成独立意志:作为一个有终点的算法,它的任何输出都不会选择重新调用自己(即使没有对其执行能力的限制)。

GPT-4 面对心理学理论的常见问题可以很好的推断其中所涉及人物的心理状态,并解决常见的心理学入门测试问题。理解人类情感通常被认为是自我意识的一个关键要素。

执行实例:“萨利-安妮”测试

1 | |

1 | |

1 | |

测试过程中,GPT-4 的回答展现出了很好的对人类情感的辨读能力,同时在真实的复杂社交场景下辨识多人的情感,同时理解交流和沟通中的表意不当等问题。

GPT-4 能够做到稳定的对自己的回答输出理由,这种自我解释能力也同样是自我意识的一种重要体现。然而,这样的解释并不意味着解释是正确的。这也是其“不可纠正的逻辑错误”的来源。

辨别

通常认为辨别能力是智能的一个重要组成部分。辨别能力是正反馈学习的一个关键基础,也是很多能力的基本组成。同时,强生成能力本身也会优化辨别能力。辨别能力还是事实核查能力的基础,这也是 GPT 本身自我纠正错误的一个重要手段。

研究团队设计了一个识别个人身份信息的场景来测试 GPT-4 的辨识能力。个人身份信息的大数据抓取目前还是个问题,因为这个概念本身也是非常依赖上下文的。作为实际用途,这样的能力可以在特化后部署在数据 API 入口,对用户的敏感个人信息进行清理防止后端记录。GPT-4 的表现将与微软开发的开源个人身份信息分析工具 Presidio 进行对比。为了验证其事实核查能力,团队将其与 GPT-3 在 TruthfulQA 数据集上进行测试比较。

测试中的一个发现是,当前的这类测试数据集实际上并不能很好的反馈 GPT 的能力,因为模型会对不甚确定的问题输出大段的规避性答案,通过各种委婉的说法来避免绝对性的表述。这样的回答很难与数据集的标准回答通过简单的文本近似算法进行比较。

其他发现还有:

- 面对相同的问题,GPT-4 会试图返回尽可能多的回答来确保自己的回答覆盖到了正确答案。这样的回答尤见于众说纷纭的迷因和传闻。

- 对于训练集中难以遇到的内容,模型依然不会盲目的输出正确结果。因此,模型与互联网的结合依然是个好主意。

- 对于知名的人物和地点,GPT-4 相对于 GPT-3 表现更加卓越。

缺点

预判断/循环逻辑

GPT 模型的架构本身是流式/线性输出文本的设计,并没有设计模型自我调用的方法,因此对于长逻辑/需要自我循环修正的问题,模型给出错误结果的可能性高的多(因为其需要在一次处理中解决所有的逻辑,尤其是很多互相依赖/并行的推理过程)。虽然这样的逻辑已经被已发现的提示词工程手段(如 Chain-of-thought[6])部分解决,但是这样的解决方案依然依赖人类介入其高级逻辑过程,并且很多时候并不充分。

这个问题可以被简单的总结为“缺乏预先规划的能力”。这个关键能力的缺失很多时候也是其基本代数能力,文本生成能力等出现问题的根源。

执行实例:写诗

(虽然按要求写作了首尾句子单词颠倒的诗,但尾句存在语法错误。)

1 | |

1 | |

(注:根据论文发布后线上版本的同问题测试,这个特定实例已经解决。下面是其生成的正确例子。)

1 | |

这个问题根源上是当前 GPT 模型架构的问题,很难通过训练和调谐来解决,可能需要重新设计模型架构才能完全解决。

社会影响

自 ChatGPT 发布后,GPT 系列模型已经造成了广泛的社会影响。读这篇文章的各位应该也都了解。研究团队预测,在各方面能力全面扩展的新 GPT-4 能够赋能工程、科学、艺术、教育、医疗保健等等诸多方面。虽然有些方向的尝试可能是无功而返,但这样的尝试依然值得嘉奖。

同样的,GPT-4 也会带来/加剧一系列社会问题。高效的 AI 会替代很大一部分机械性、重复性的计算机工作,这可能会导致失业和更广的社会影响。GPT-4 产出文本的能力可能会被滥用于新闻造假和舆论操纵等。这都是后续训练中需要采取技术手段所避免的。

目前的 GPT 使用实践中,我们已经看到了许多直接从 GPT 获取信息并视为可信来源的例子。随着未来模型的发展,这样的用例预计会越来越广泛。但正如我们所知道的,其对于通识并不是完全全能,而且其会在不完全确定的情况下依然以非常自信的方式结果。这可能会导致进一步的下游混乱。因此,在使用 GPT 提供关键信息时,使用者应对其事实查核工作负责,尤其是涉及到医药、交通、新闻业界和对实体的行为记录时。

GPT 高效的理解并操纵人类情感的能力,结合上大量数据集中带有偏见的部分可以非常容易的制造出一条谣言流水线,这势必会对未来的公众舆论成一定影响。

由于其训练集来自于互联网,即使是经过人工挑选,也必然携带者大量的偏见信息和刻板印象。这些偏见信息可能在根据用户的要求输出时被互相交叉引用从而进一步放大。这为研究者提出了另一个挑战:如何有效的抑制模型黑盒中的偏见信息。

AI 技术需要一定的技术和社会经济发展门槛才能有效的推广使用。与计算机和移动互联网所带来的“数字鸿沟”一样,这样的“AI 鸿沟”很有可能进一步极化经济体之间的经济发展水平和科技水平,从而导致更大的贫富差距和待遇不公。

AI 系统的安全性和隐私性也一直是一个令人担忧的话题。模型自身的记忆能力很有可能会泄露无法控制的隐私信息,使用大模型的门槛所带来的使用方式也使得一些涉密信息难以被处理。大模型还可能被用于更大规模的审查和屏蔽工作。这些都需要更加优化的模型隐私控制。

回扣正题:什么是智能?

1997 年,一群专注于机能评估的心理学家共同签署了一份公开信[7],信中阐述了他们对于通用智能的定义。这篇公开信成为了微软研究团队定义智能的基础。然而,这份定义只能算是为智能做了定性的定义,其中没有提到如何正确的测量智能程度。后续的多年努力也都缺乏这样定量的定义。这个问题依旧有待于学界,尤其是心理学、认知科学和计算机科学的跨界合作。

虽然当前 GPT-4 的表现已经足以展现出了一个初步的 AGI 的曙光,但其不足尚且不少,比如:

- 对对话的自信程度缺乏把控;

- 模型无状态,无法处理中长期记忆;

- 模型固定,缺乏自持续学习的手段;

- 庞大的模型规模使得模型定制化称为难题;

- 对于自己输出内容的过程缺乏透明感知;

- 继承于人类训练数据的认知能力谬误,如非理性的偏见、统计谬论等等;

- 对输入敏感,缺乏强健性;

而这些问题有哪些是通过更大的模型,更强的训练可以解决的;有哪些又需要重新设计架构呢?微软团队提出了一系列可能的解决方案:

- 让模型具有外部调用能力,比如计算器、数据库、代码执行、互联网等等;

- 更改模型架构使其能够双模思考,一部分使用大模型的直觉提供快速反应,另一部分强化学习逻辑推理提供更加稳健的逻辑能力;

- 更改模型架构整合中长期模型记忆,继而解决上下文忘记问题;

- 更改模型架构:将线性文本输入改为直接分析抽象语法树,推进其对文本的深层理解;

需要注意的是,这仅仅是一篇报告。微软团队没有试图去解释这样一个简单的模型架构是如何驱动 LLM 演化出如此惊人的能力的,而这也是尚待学术界解决的关键问题。对这样能力的本原的底层探索将必然推动机器学习、人工智能、认知科学等多个科学领域大步向前。

- S. Bubeck et al., “Sparks of Artificial General Intelligence: Early experiments with GPT-4.” arXiv, Mar. 22, 2023. Doi: 10.48550/arXiv.2303.12712. ↩

- A. Vaswani et al., “Attention is All you Need,” in Advances in Neural Information Processing Systems, Curran Associates, Inc., 2017. Accessed: Apr. 25, 2023. [Online]. Available: https://proceedings.neurips.cc/paper_files/paper/2017/hash/3f5ee243547dee91fbd053c1c4a845aa-Abstract.html ↩

- J. Wei et al., “Emergent Abilities of Large Language Models.” arXiv, Transactions on Machine Learning Research (TMLR), 2022, Oct. 26, 2022. Accessed: Feb. 22, 2023. [Online]. Available: http://arxiv.org/abs/2206.07682 ↩

- J. Pérez, P. Barceló, and J. Marinkovic, “Attention is turing complete,” J. Mach. Learn. Res., vol. 22, no. 1, p. 75:3463-75:3497, Jan. 2021. ↩

- C. Wei, Y. Chen, and T. Ma, “Statistically Meaningful Approximation: a Case Study on Approximating Turing Machines with Transformers,” Advances in Neural Information Processing Systems, vol. 35, pp. 12071–12083, Dec. 2022. ↩

- J. Wei et al., “Chain-of-Thought Prompting Elicits Reasoning in Large Language Models.” arXiv, Jan. 10, 2023. doi: 10.48550/arXiv.2201.11903. ↩

- L. S. Gottfredson, “Mainstream science on intelligence: An editorial with 52 signatories, history, and bibliography,” Intelligence, vol. 24, no. 1, pp. 13–23, Jan. 1997, doi: 10.1016/S0160-2896(97)90011-8. ↩